¿Cómo funciona ChatGPT?

Por Antonio Richaud, Publicado el 17 de Abril de 2024

En los últimos años, los modelos de lenguaje como ChatGPT han transformado la forma en que interactuamos con la tecnología. Desde asistentes virtuales hasta generación automática de texto, estos modelos nos sorprenden con su capacidad para entender y generar lenguaje humano de manera fluida y coherente. Pero, ¿alguna vez te has preguntado cómo funciona ChatGPT detrás de escena? ¿Qué hace posible que este modelo responda preguntas, mantenga conversaciones y produzca contenido con un nivel impresionante de detalle?

ChatGPT es más que solo un modelo de lenguaje: es el resultado de años de investigación en inteligencia artificial, procesamiento del lenguaje natural (NLP), y aprendizaje profundo. En este artículo, vamos a sumergirnos en el corazón de ChatGPT para entender cómo funciona, desde su arquitectura técnica hasta los datos que lo entrenan, y exploraremos cómo se entrenan estos modelos para convertirlos en las poderosas herramientas que son hoy.

Prepárate para un recorrido técnico pero accesible que te ayudará a entender qué hay detrás de ChatGPT, sus capacidades, sus limitaciones, y el futuro de esta tecnología. Ya seas un desarrollador, un entusiasta de la IA, o simplemente alguien curioso, este artículo está diseñado para que aprendas algo nuevo y emocionante sobre uno de los avances tecnológicos más importantes de nuestra era.

1. ¿Qué es ChatGPT?

ChatGPT es un modelo de lenguaje avanzado creado por OpenAI que utiliza técnicas de inteligencia artificial para entender y generar texto en lenguaje natural. Basado en la arquitectura GPT (Generative Pre-trained Transformer), ChatGPT es capaz de responder preguntas, mantener conversaciones, crear contenido, e incluso ayudar en la programación, todo a partir de una simple entrada de texto.

GPT: el motor detrás de ChatGPT

Para entender qué hace a ChatGPT tan especial, primero necesitamos conocer qué es GPT. GPT, que significa "Generative Pre-trained Transformer", es una serie de modelos de lenguaje desarrollados por OpenAI. Estos modelos son entrenados en grandes cantidades de texto para aprender patrones en el lenguaje y luego generar texto coherente basado en un input. La versión de GPT que da vida a ChatGPT es la GPT-4, la cual es una de las versiones más avanzadas hasta la fecha.

A diferencia de los modelos tradicionales de procesamiento del lenguaje natural (NLP), que suelen requerir mucho trabajo para diseñar funciones manualmente, GPT utiliza una arquitectura basada en transformers, una estructura de red neuronal que permite al modelo prestar atención a diferentes partes de una oración o un documento a la vez. Esta capacidad de "atención" es lo que permite que GPT entienda contextos complejos y genere respuestas coherentes incluso en conversaciones largas.

Procesamiento del lenguaje natural y redes neuronales

ChatGPT pertenece a la categoría de modelos de procesamiento del lenguaje natural (NLP), que son herramientas diseñadas para comprender, interpretar y generar lenguaje humano. Estos modelos utilizan redes neuronales, en particular redes neuronales profundas (deep learning), para aprender patrones en datos textuales. A través del entrenamiento, las redes neuronales de ChatGPT aprenden a reconocer las estructuras y las relaciones entre palabras, frases y conceptos, lo que les permite generar respuestas que parecen casi humanas.

Diferencias entre ChatGPT y otros modelos de lenguaje

Aunque hay muchos modelos de lenguaje y herramientas de NLP, ChatGPT se destaca por su capacidad de generar respuestas detalladas y coherentes en una amplia variedad de contextos. Algunas de las diferencias clave entre ChatGPT y otros modelos incluyen:

- Escalabilidad: ChatGPT está basado en GPT-4, que es un modelo extremadamente grande con miles de millones de parámetros. Esto le permite manejar tareas complejas y generar respuestas detalladas.

- Entrenamiento a gran escala: ChatGPT ha sido entrenado en una vasta cantidad de datos textuales, lo que le permite tener un conocimiento amplio y poder responder a preguntas en diversos temas.

- Fine-tuning: ChatGPT ha sido ajustado específicamente para mejorar su capacidad de mantener conversaciones y generar texto de manera más natural y coherente.

En resumen, ChatGPT es un modelo de lenguaje poderoso que utiliza la arquitectura GPT para generar texto en lenguaje natural. Su capacidad para entender y responder a entradas de texto de manera coherente y detallada lo hace ideal para una variedad de aplicaciones, desde asistentes virtuales hasta generación de contenido.

2. ¿Cómo funciona ChatGPT?

Ahora que sabemos qué es ChatGPT, vamos a sumergirnos en cómo funciona. El proceso que ChatGPT sigue para generar una respuesta comienza cuando introduces un texto o una pregunta. A partir de ahí, el modelo procesa esa entrada y genera una respuesta en lenguaje natural. Aunque el proceso puede parecer simple desde el exterior, detrás de escena hay una compleja arquitectura de red neuronal y múltiples etapas de procesamiento que hacen posible este milagro tecnológico.

El papel de los Transformers en ChatGPT

El núcleo de ChatGPT es un modelo llamado Transformer, que es una arquitectura de red neuronal diseñada específicamente para manejar secuencias de datos, como texto. A diferencia de las redes neuronales tradicionales, que procesan datos de manera secuencial (es decir, palabra por palabra), los Transformers pueden analizar toda la secuencia de entrada al mismo tiempo. Esto les permite comprender mejor el contexto completo de una oración o un párrafo.

Un Transformer está compuesto por dos partes principales: el codificador y el decodificador. Sin embargo, en modelos como GPT, solo se utiliza el decodificador, que se encarga de predecir la siguiente palabra en una secuencia. A medida que se genera cada palabra, se añade al texto generado, y el proceso se repite hasta que se completa la respuesta. Esta capacidad de predecir y generar palabras en función del contexto es lo que permite a ChatGPT producir respuestas coherentes.

Atención (Attention): Cómo ChatGPT se enfoca en diferentes partes del texto

Un concepto clave en los Transformers, y por ende en ChatGPT, es la "atención". En términos simples, la atención permite que el modelo se concentre en diferentes partes del texto a medida que procesa una entrada. Esto es especialmente útil en oraciones largas o complejas, donde el significado de una palabra puede depender de otras palabras que aparecen antes o después en la secuencia.

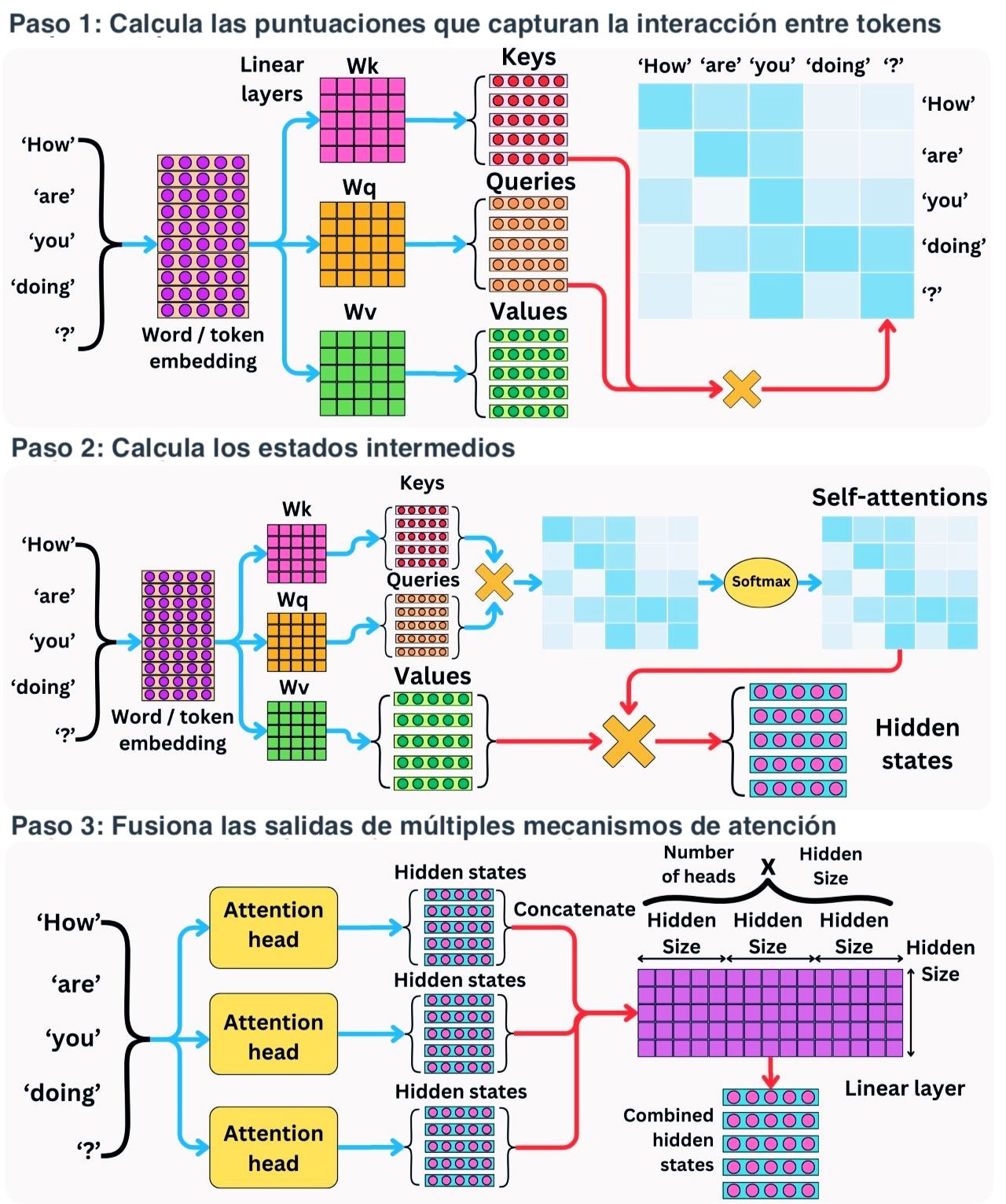

Para entender mejor cómo funciona este proceso, la siguiente imagen ilustra cómo se calculan las puntuaciones de atención y cómo se usan para generar las representaciones contextuales de cada palabra en una secuencia:

Como puedes ver, el proceso de atención se realiza en tres pasos principales:

- Calcular las puntuaciones de atención: Cada palabra en la secuencia se representa como un vector de "consulta" (query), "clave" (key), y "valor" (value). Estos vectores se usan para calcular cuánto debe "atender" el modelo a otras palabras en la secuencia.

- Calcular los estados intermedios: Las puntuaciones de atención se usan para calcular una representación ponderada (self-attention) de cada palabra, considerando el contexto de la secuencia completa.

- Fusionar las salidas de múltiples mecanismos de atención: El modelo usa varios "cabezas de atención" (attention heads) para capturar diferentes aspectos del contexto. Las salidas de estas cabezas se combinan y se pasan a través de una capa lineal para generar la representación final de la palabra.

Este proceso se repite en cada capa del Transformer, lo que permite al modelo refinar su comprensión del texto y generar respuestas más precisas y coherentes.

# Ejemplo de cómo se podría implementar la autoatención en una capa de Transformer

import torch

import torch.nn.functional as F

def attention(query, key, value):

# Calcular las puntuaciones de atención

scores = torch.matmul(query, key.transpose(-2, -1)) / torch.sqrt(query.size(-1))

# Aplicar softmax para obtener las probabilidades de atención

attention_weights = F.softmax(scores, dim=-1)

# Multiplicar las probabilidades por los valores para obtener el contexto

context = torch.matmul(attention_weights, value)

return context, attention_weights

En este snippet, la función attention toma las matrices de consulta

(query), clave (key) y valor (value) y calcula las

puntuaciones de atención. Luego, se aplica la función softmax para obtener las probabilidades de

atención, que se usan para ponderar los valores y obtener el contexto final. Este proceso se

realiza en cada capa del Transformer para generar una representación contextual del texto.

La arquitectura GPT: Capas de atención y generación de texto

La arquitectura GPT, utilizada en ChatGPT, está formada por múltiples capas de Transformer, específicamente capas de autoatención. Cada capa tiene su propia versión del proceso de atención que acabamos de describir, lo que permite al modelo refinar su comprensión del texto en cada nivel. Cuantas más capas tiene un modelo, más complejas y matizadas pueden ser sus representaciones del lenguaje.

A medida que la entrada pasa por cada capa, el modelo ajusta su "comprensión" del texto. Finalmente, en la última capa, el modelo genera una predicción sobre cuál debería ser la siguiente palabra en la secuencia. Este proceso se repite para cada palabra hasta que se completa la respuesta.

Todo esto ocurre en cuestión de milisegundos, lo que permite a ChatGPT generar respuestas casi instantáneas. Aunque la arquitectura es compleja, el resultado final es una capacidad impresionante para generar texto en lenguaje natural que parece haber sido escrito por un ser humano.

3. Entrenamiento de ChatGPT

El rendimiento impresionante de ChatGPT no ocurre por casualidad; es el resultado de un proceso de entrenamiento complejo y meticuloso. Entrenar un modelo como ChatGPT implica dos fases principales: el pre-entrenamiento y el ajuste fino (fine-tuning). A continuación, exploraremos cada una de estas fases en detalle, así como los datos utilizados y los recursos computacionales necesarios para llevar a cabo este proceso.

Pre-entrenamiento: El corazón del aprendizaje

El pre-entrenamiento es la primera fase en el desarrollo de ChatGPT. Durante esta fase, el modelo se entrena en grandes cantidades de texto para aprender las estructuras y patrones del lenguaje. Se alimenta al modelo con enormes cantidades de texto, que pueden incluir libros, artículos, sitios web, y otras fuentes de datos textuales. El objetivo del pre-entrenamiento es que el modelo aprenda a predecir la siguiente palabra en una secuencia, una tarea conocida como "modelado de lenguaje".

Durante este proceso, el modelo GPT genera representaciones de los datos de entrada mediante la arquitectura de Transformer que ya discutimos. A medida que pasa por los datos, el modelo ajusta sus pesos internos (parámetros) para minimizar el error entre la predicción y la palabra real. Este aprendizaje permite al modelo captar una amplia comprensión del lenguaje, incluyendo gramática, coherencia, y algo de sentido común.

El pre-entrenamiento es intensivo en recursos, ya que se lleva a cabo utilizando grandes clústeres de GPUs (Unidades de Procesamiento Gráfico) o TPUs (Unidades de Procesamiento Tensorial). El proceso puede durar semanas o incluso meses, dependiendo del tamaño del modelo y la cantidad de datos. Al final de esta fase, el modelo tiene una sólida base en el lenguaje, pero aún no está optimizado para tareas específicas.

Ajuste fino (Fine-tuning): Haciendo a ChatGPT más útil

Después del pre-entrenamiento, el modelo pasa por una fase de ajuste fino, que es donde se optimiza para tareas específicas, como la generación de respuestas conversacionales. En esta fase, el modelo se entrena en un conjunto de datos más pequeño y más específico, que a menudo incluye ejemplos de conversaciones humanas. Este proceso ayuda a afinar las habilidades del modelo, haciendo que sus respuestas sean más relevantes y útiles para los usuarios.

El ajuste fino también es donde se puede abordar el sesgo del modelo. Debido a que el pre-entrenamiento utiliza datos de internet, donde abundan los sesgos y la desinformación, es crucial utilizar técnicas para mitigar estos problemas. Por ejemplo, OpenAI utiliza revisores humanos y algoritmos adicionales para ajustar el comportamiento del modelo y reducir la probabilidad de que genere respuestas inapropiadas o sesgadas.

Durante el ajuste fino, también se pueden utilizar técnicas como el "reinforcement learning from human feedback" (aprendizaje por refuerzo a partir de la retroalimentación humana, o RLHF). En este enfoque, los evaluadores humanos interactúan con el modelo, clasifican sus respuestas, y esas clasificaciones se utilizan para ajustar el modelo, mejorando su rendimiento en futuras interacciones.

# Ejemplo básico de ajuste fino usando PyTorch

from transformers import GPT2LMHeadModel, GPT2Tokenizer, AdamW, get_linear_schedule_with_warmup

import torch

# Cargar el modelo pre-entrenado GPT-2 y el tokenizer

model = GPT2LMHeadModel.from_pretrained("gpt2")

tokenizer = GPT2Tokenizer.from_pretrained("gpt2")

# Preparar los datos de entrada

texts = ["Tu ejemplo de texto para el ajuste fino."]

inputs = tokenizer(texts, return_tensors="pt", padding=True, truncation=True, max_length=512)

# Configurar el optimizador y el programador de aprendizaje

optimizer = AdamW(model.parameters(), lr=5e-5)

scheduler = get_linear_schedule_with_warmup(optimizer, num_warmup_steps=0, num_training_steps=100)

# Ciclo de entrenamiento

model.train()

for epoch in range(3):

outputs = model(**inputs, labels=inputs["input_ids"])

loss = outputs.loss

loss.backward()

optimizer.step()

scheduler.step()

optimizer.zero_grad()

print(f"Epoch {epoch+1} completed with loss: {loss.item()}")

En este snippet, utilizamos PyTorch y la librería Transformers de Hugging Face para realizar un ajuste fino básico en un modelo GPT-2. El proceso es similar al que se realiza en modelos como ChatGPT, aunque a una escala mucho mayor.

Datos de entrenamiento: La materia prima de ChatGPT

Uno de los componentes más importantes en el entrenamiento de ChatGPT es el conjunto de datos utilizado. Para el pre-entrenamiento, se utilizan enormes corpus de texto que pueden incluir libros, artículos, y contenido web. Estos datos deben ser lo suficientemente diversos para que el modelo pueda aprender a manejar diferentes estilos de lenguaje y temas.

Sin embargo, el origen de estos datos también plantea desafíos. Los datos de internet, por ejemplo, pueden contener sesgos o información incorrecta. Es por eso que, durante el ajuste fino, se presta especial atención a la calidad de los datos. Se pueden utilizar conjuntos de datos curados que pasan por procesos de revisión para asegurar que el modelo aprenda de fuentes confiables y representativas.

Recursos computacionales: El poder detrás del entrenamiento

Entrenar un modelo como ChatGPT requiere una cantidad masiva de recursos computacionales. El proceso involucra el uso de GPUs y TPUs distribuidas a lo largo de grandes clústeres, que trabajan en paralelo para manejar el enorme volumen de cálculos necesarios. Estos recursos permiten que el modelo procese terabytes de datos y ajuste millones de parámetros.

Para darte una idea de la magnitud, modelos como GPT-4 pueden tener cientos de miles de millones de parámetros, lo que requiere una infraestructura computacional avanzada para entrenarlos en un tiempo razonable. OpenAI, por ejemplo, utiliza supercomputadoras especializadas para realizar este tipo de entrenamientos, que pueden durar semanas o incluso meses.

En resumen, el entrenamiento de ChatGPT es un proceso intensivo que combina grandes volúmenes de datos, técnicas avanzadas de ajuste, y una infraestructura computacional poderosa. Estos elementos juntos permiten que ChatGPT sea un modelo de lenguaje altamente capaz y flexible, listo para una variedad de aplicaciones en el mundo real.

4. Limitaciones y desafíos de ChatGPT

Aunque ChatGPT es una herramienta poderosa y sorprendente, no está exenta de limitaciones. Comprender estas limitaciones es esencial para utilizar el modelo de manera efectiva y evitar posibles malentendidos sobre sus capacidades. Además, el uso de modelos de lenguaje como ChatGPT plantea desafíos éticos significativos que deben ser abordados para asegurar que su impacto sea positivo y responsable.

Limitaciones actuales de ChatGPT

ChatGPT, al igual que otros modelos de lenguaje, enfrenta varias limitaciones inherentes a su diseño y entrenamiento. Aquí te explico algunas de las más importantes:

- Sesgo en las respuestas: Dado que ChatGPT se entrena en datos que provienen de internet, está expuesto a los mismos sesgos presentes en estos datos. Esto puede llevar a que el modelo reproduzca estereotipos o brinde respuestas que no son neutrales. Aunque se aplican técnicas de mitigación durante el ajuste fino, los sesgos aún pueden aparecer en las respuestas del modelo.

- Alucinaciones: Una de las limitaciones más notorias de ChatGPT es su tendencia a "alucinar". Esto significa que el modelo puede generar respuestas que parecen plausibles pero que en realidad son incorrectas o no tienen sentido. Estas alucinaciones pueden ser especialmente problemáticas en contextos donde se espera información precisa y confiable.

- Falta de comprensión real: Aunque ChatGPT es muy bueno generando texto coherente, no comprende realmente el significado de lo que está diciendo. Es un modelo estadístico que genera respuestas basadas en patrones aprendidos, pero carece de una comprensión profunda o intencionalidad.

- Dependencia del contexto: ChatGPT a veces tiene dificultades para mantener el contexto en conversaciones largas. Puede repetir información, olvidar detalles anteriores, o incluso cambiar de tema de manera abrupta si el contexto no se maneja adecuadamente.

Estas limitaciones son el resultado de la naturaleza del entrenamiento y la arquitectura del modelo. Si bien ChatGPT es impresionante en muchas áreas, es importante recordar que no es infalible y debe usarse con precaución, especialmente en aplicaciones críticas.

Desafíos éticos: Privacidad, manipulación y uso indebido

El uso de ChatGPT también plantea varios desafíos éticos que deben ser considerados. Aquí te detallo algunos de los más destacados:

1. Privacidad

Uno de los principales desafíos es la privacidad de los datos. Dado que ChatGPT puede procesar grandes cantidades de información textual, existe el riesgo de que maneje datos sensibles o privados de manera inapropiada. Si un usuario introduce información personal en una interacción con ChatGPT, esa información podría ser retenida y potencialmente utilizada en respuestas futuras, lo que plantea preocupaciones sobre la privacidad.

2. Manipulación de información

ChatGPT tiene la capacidad de generar texto convincente, lo que podría ser explotado para manipular o desinformar. Por ejemplo, el modelo podría ser utilizado para crear contenido engañoso, difundir rumores, o incluso influir en la opinión pública. La facilidad con la que ChatGPT puede generar grandes volúmenes de texto hace que este sea un riesgo real.

3. Uso indebido y automatización

Existe el riesgo de que ChatGPT sea utilizado para automatizar tareas de manera que desplace trabajos o que se emplee en actividades maliciosas, como la creación de spam a gran escala o el desarrollo de malware basado en instrucciones generadas por el modelo. Además, su capacidad para mantener conversaciones humanas podría ser utilizada para suplantar identidades o realizar fraudes.

Abordar estos desafíos requiere un enfoque cuidadoso en la implementación y regulación del uso de ChatGPT. OpenAI y otras organizaciones que desarrollan modelos de lenguaje avanzado están trabajando para mitigar estos riesgos mediante la implementación de medidas de seguridad y prácticas responsables de IA.

Cómo OpenAI aborda estos desafíos

Consciente de estas limitaciones y desafíos éticos, OpenAI ha implementado varias estrategias para mitigar los riesgos asociados con el uso de ChatGPT:

- Moderación y control: Se han desarrollado sistemas de moderación que ayudan a filtrar y bloquear contenido inapropiado generado por ChatGPT. Estos sistemas están diseñados para evitar que el modelo produzca respuestas ofensivas, dañinas o engañosas.

- Mejoras continuas: OpenAI está en un proceso constante de mejorar ChatGPT mediante la retroalimentación de los usuarios y evaluadores humanos. Esto incluye la implementación de técnicas como el RLHF para ajustar el comportamiento del modelo en función de la retroalimentación directa.

- Transparencia y responsabilidad: OpenAI se esfuerza por ser transparente sobre las capacidades y limitaciones de ChatGPT, alentando un uso responsable de la tecnología. Además, promueven la investigación en IA ética y trabajan con la comunidad para desarrollar normas y directrices para el uso seguro de los modelos de lenguaje.

Aunque todavía hay mucho trabajo por hacer, estos esfuerzos son pasos importantes para asegurar que ChatGPT y tecnologías similares se utilicen de manera ética y segura, minimizando el impacto negativo mientras se maximiza el beneficio.

5. Aplicaciones prácticas de ChatGPT

ChatGPT no solo es una curiosidad técnica; también tiene aplicaciones prácticas que ya están transformando diversas industrias. Desde el servicio al cliente hasta la creación de contenido y la asistencia en programación, ChatGPT se está integrando en productos y servicios para mejorar la eficiencia y ofrecer experiencias más ricas a los usuarios. En esta sección, exploraremos algunas de las aplicaciones más comunes de ChatGPT y cómo puedes aprovechar esta tecnología en tus propios proyectos.

Casos de uso: ¿Dónde es más útil ChatGPT?

ChatGPT es extremadamente versátil y se puede aplicar en una amplia variedad de contextos. Aquí te detallo algunos de los casos de uso más comunes:

1. Asistencia en servicio al cliente

Una de las aplicaciones más populares de ChatGPT es en el servicio al cliente. Los chatbots basados en GPT pueden responder preguntas frecuentes, ayudar a los clientes a resolver problemas, y guiar a los usuarios a través de procesos, como la compra de productos o la configuración de servicios. La capacidad de ChatGPT para generar respuestas naturales y personalizadas mejora la experiencia del cliente, reduciendo la necesidad de intervención humana en tareas repetitivas.

2. Creación de contenido

ChatGPT es una herramienta poderosa para la creación de contenido. Ya sea para redactar artículos, generar ideas para publicaciones en redes sociales, o incluso escribir código, ChatGPT puede producir texto de alta calidad en cuestión de segundos. Esto es particularmente útil para escritores, blogueros y creadores de contenido que necesitan generar grandes volúmenes de texto en poco tiempo.

3. Educación y tutoría

En el ámbito educativo, ChatGPT se está utilizando para desarrollar herramientas de tutoría virtual. Los estudiantes pueden interactuar con modelos basados en GPT para recibir explicaciones, resolver problemas matemáticos, o aprender nuevos conceptos. La capacidad del modelo para ajustar su lenguaje al nivel del usuario lo convierte en un tutor personalizado ideal, que puede ayudar a los estudiantes a aprender a su propio ritmo.

4. Asistencia en programación

Para los desarrolladores, ChatGPT puede actuar como un asistente de programación, proporcionando fragmentos de código, explicaciones, y soluciones a problemas comunes. Por ejemplo, los desarrolladores pueden pedir a ChatGPT que genere una función en un lenguaje de programación específico, y el modelo proporcionará un snippet de código que puede ser utilizado directamente en el proyecto. Esto ahorra tiempo y puede ser especialmente útil para principiantes que están aprendiendo a programar.

# Ejemplo: Generación de una función en Python para sumar dos números

def sumar(a, b):

return a + b

resultado = sumar(3, 5)

print(f"El resultado de la suma es: {resultado}")

En este snippet, ChatGPT genera una función simple en Python que suma dos números. Este tipo de asistencia puede ser invaluable para los desarrolladores que necesitan soluciones rápidas o inspiración para resolver problemas de codificación.

5. Integración en productos y servicios

Muchas empresas están integrando ChatGPT directamente en sus productos y servicios para mejorar la experiencia del usuario. Esto incluye desde aplicaciones móviles hasta plataformas de comercio electrónico, donde los usuarios pueden interactuar con un chatbot impulsado por GPT para obtener recomendaciones personalizadas, asistencia en tiempo real, o simplemente para recibir respuestas rápidas a sus preguntas.

La flexibilidad de ChatGPT permite que se adapte a una amplia variedad de industrias, desde la atención médica hasta la banca, proporcionando valor en casi cualquier contexto en el que la interacción basada en texto sea relevante.

Cómo integrar ChatGPT en tus aplicaciones

Si estás interesado en integrar ChatGPT en tus propias aplicaciones, OpenAI ofrece una API que facilita este proceso. A continuación, te muestro un ejemplo básico de cómo podrías hacerlo utilizando Python:

import openai

# Configurar la clave API

openai.api_key = "tu-clave-api"

# Realizar una consulta a la API de ChatGPT

respuesta = openai.Completion.create(

engine="gpt-4",

prompt="Escribe un poema sobre la inteligencia artificial.",

max_tokens=100

)

# Mostrar la respuesta generada por ChatGPT

print(respuesta.choices[0].text.strip())

En este ejemplo, utilizamos la API de OpenAI para generar un poema sobre inteligencia artificial. La API es flexible y permite personalizar el comportamiento de ChatGPT para adaptarlo a diferentes necesidades, como la longitud de la respuesta o el tono del texto.

Integrar ChatGPT en tus aplicaciones puede ofrecer una ventaja competitiva significativa, permitiéndote ofrecer a tus usuarios interacciones más ricas y personalizadas sin la necesidad de desarrollar un modelo de lenguaje desde cero.

En resumen, ChatGPT es una herramienta increíblemente versátil que se puede aplicar en una amplia variedad de contextos, desde la asistencia en servicio al cliente hasta la creación de contenido y la programación. Su capacidad para generar texto natural y coherente lo convierte en un aliado poderoso para cualquier desarrollador o empresa que busque mejorar sus productos y servicios.

Conclusión

ChatGPT representa un gran avance en el campo de la inteligencia artificial y el procesamiento del lenguaje natural. Su capacidad para generar texto coherente y responder a una amplia variedad de consultas lo convierte en una herramienta increíblemente útil en diversas aplicaciones, desde la asistencia en servicio al cliente hasta la creación de contenido y la educación.

A lo largo de este artículo, hemos explorado cómo funciona ChatGPT, desde su arquitectura interna basada en Transformers y su proceso de entrenamiento, hasta las limitaciones y desafíos éticos que enfrenta. También hemos visto cómo puedes integrar esta tecnología en tus propios proyectos, aprovechando la API de OpenAI para desarrollar aplicaciones más inteligentes y responsivas.

Sin embargo, es importante recordar que, aunque ChatGPT es una herramienta poderosa, no está exenta de limitaciones y riesgos. Usarla de manera responsable y consciente es clave para maximizar sus beneficios mientras se minimizan los posibles impactos negativos.

Con la rápida evolución de la inteligencia artificial, ChatGPT y tecnologías similares seguirán transformando la manera en que interactuamos con las máquinas, abriendo nuevas oportunidades y planteando nuevos desafíos. Mantenernos informados y preparados para estos cambios será esencial para aprovechar al máximo esta revolución tecnológica.

Recursos adicionales

- Documentación oficial de OpenAI sobre GPT: Una guía completa sobre la serie de modelos GPT desarrollados por OpenAI.

- Documentación de Transformers de Hugging Face: Una referencia para trabajar con Transformers, incluyendo ejemplos de cómo implementar y ajustar modelos GPT.

- Paper: "Language Models are Few-Shot Learners": El artículo de investigación que introdujo GPT-3, explicando en detalle cómo funcionan estos modelos y sus capacidades.

- Video explicativo sobre Transformers y GPT: Un video de YouTube que desglosa cómo funcionan los Transformers y su aplicación en modelos como GPT.

- Guía de la API de OpenAI: Instrucciones sobre cómo utilizar la API de OpenAI para integrar ChatGPT en tus aplicaciones.

- Guía de TensorFlow sobre Transformers: Un recurso para entender y trabajar con la arquitectura Transformer en TensorFlow.