De neuronas biológicas a neuronas artificiales: ¿cómo el cerebro inspira la inteligencia artificial?

Por Antonio Richaud, Publicado el 22 de Septiembre de 2025

1. Introducción: El puente entre biología y tecnología

Desde hace décadas, la inteligencia artificial ha buscado inspiración en el sistema más complejo y eficiente que conocemos: el cerebro humano. Este órgano, formado por miles de millones de neuronas interconectadas, es capaz de aprender, adaptarse y resolver problemas de una manera que aún hoy nos resulta sorprendente. Pero lo fascinante es que, al observar cómo funciona una sola neurona, los científicos descubrieron una idea poderosa: si logramos imitar el proceso de “activación” de una neurona, podríamos construir máquinas que también aprendan y tomen decisiones.

Así nacieron las llamadas neuronas artificiales, unidades matemáticas que imitan el comportamiento de las neuronas biológicas. Aunque mucho más simples que sus contrapartes en el cerebro, estas neuronas artificiales se convirtieron en la base de una revolución tecnológica: las redes neuronales. Gracias a ellas, hoy contamos con sistemas capaces de reconocer rostros, traducir idiomas, diagnosticar enfermedades e incluso conducir automóviles sin intervención humana.

En este artículo, partiremos de la biología para entender cómo funciona una neurona real y veremos cómo esa inspiración se tradujo en fórmulas matemáticas y algoritmos que dieron forma a la inteligencia artificial moderna.

2. Cómo funciona una neurona biológica

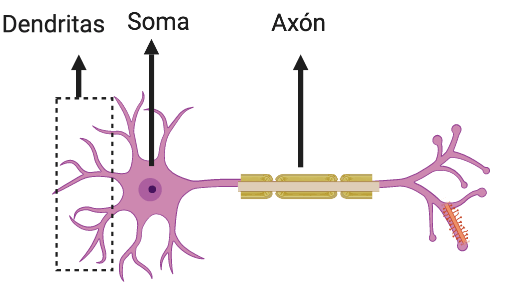

El cerebro humano está compuesto por miles de millones de neuronas que trabajan juntas como una red de comunicación altamente eficiente. Cada neurona recibe señales de otras a través de extensiones llamadas dendritas. Estas señales se concentran en el soma o cuerpo celular, donde también se encuentra el núcleo. El soma actúa como un centro de integración: decide si la información acumulada es lo suficientemente fuerte para generar una respuesta.

Si la señal supera un cierto umbral, la neurona “dispara” un impulso eléctrico conocido como potencial de acción. Este impulso viaja por una extensión llamada axón hasta llegar a otras neuronas, músculos o glándulas. En caso contrario, si la señal no alcanza el umbral, la neurona permanece en silencio.

En términos simples, podemos pensar en la neurona como un interruptor biológico: si recibe suficientes estímulos, se enciende; si no, permanece apagada. Este mecanismo básico, repetido miles de millones de veces en paralelo, es lo que permite al cerebro aprender, recordar y tomar decisiones.

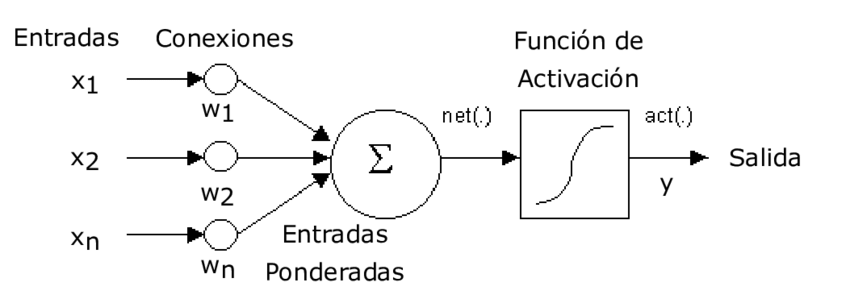

3. De la biología a las matemáticas: nacimiento de la neurona artificial

Para transformar la inspiración biológica en un modelo computacional, los científicos abstrajeron la neurona

a sus funciones esenciales:

recibir señales, integrarlas en el soma y emitir una respuesta por

el axón.

En la neurona artificial, estas etapas se representan con entradas (X), pesos

(W), un sesgo o bias (b) y una función de activación

f(·).

Matemáticamente, la neurona artificial calcula primero una suma ponderada:

Después, aplica una función de activación que determina la salida:

Esta función es el equivalente al “umbral” biológico: decide si la neurona “se enciende” y con qué intensidad.

De la neurona real a la neurona artificial

- Dendritas (entradas biológicas) ➜ Entradas

X = (X1, X2, …, Xn) - Soma (integración) ➜ Ponderación y suma

z = Σ Wi Xi + b - Umbral de activación ➜ Función de activación

f(z) - Axón (señal de salida) ➜ Salida

y = f(z) - Fuerza de conexión sináptica ➜ Pesos

W - Excitabilidad basal ➜ Bias

b

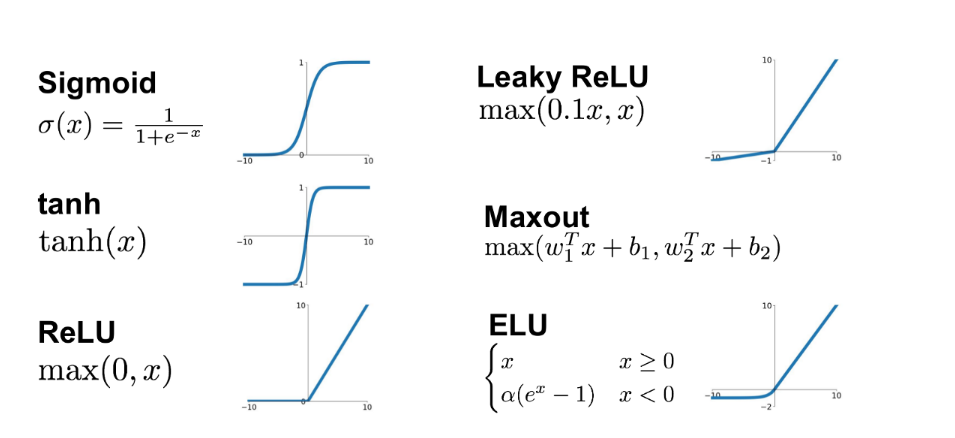

4. La función de activación: el “clic” de la neurona

En la biología, una neurona no responde de manera gradual: o bien se activa si la señal supera un cierto umbral, o bien permanece inactiva. Este fenómeno inspiró la idea de las funciones de activación en neuronas artificiales. Estas funciones deciden si la señal acumulada es lo suficientemente relevante como para generar una salida, simulando así el “clic” neuronal.

Una de las primeras funciones utilizadas fue la sigmoide:

Esta función transforma cualquier valor en un número entre 0 y 1, lo que permite interpretar la salida como una probabilidad. Por ejemplo, la probabilidad de que una imagen contenga un gato.

Más adelante surgió la ReLU (Rectified Linear Unit), que se convirtió en una de las más usadas gracias a su simplicidad y eficiencia:

A diferencia de la sigmoide, la ReLU no se satura en valores positivos y acelera el entrenamiento de redes profundas. Existen además otras variantes como la tanh, que produce valores entre -1 y 1, o la Leaky ReLU, que corrige limitaciones de la ReLU clásica. Todas ellas cumplen la misma misión: convertir la suma matemática en una decisión útil.

5. Redes neuronales: cuando las neuronas trabajan en equipo

Una sola neurona artificial es interesante, pero su verdadero poder surge cuando se conecta con muchas otras. Al igual que en el cerebro humano, donde miles de millones de neuronas se enlazan en redes complejas, en la inteligencia artificial múltiples neuronas artificiales se organizan en capas, formando lo que conocemos como redes neuronales.

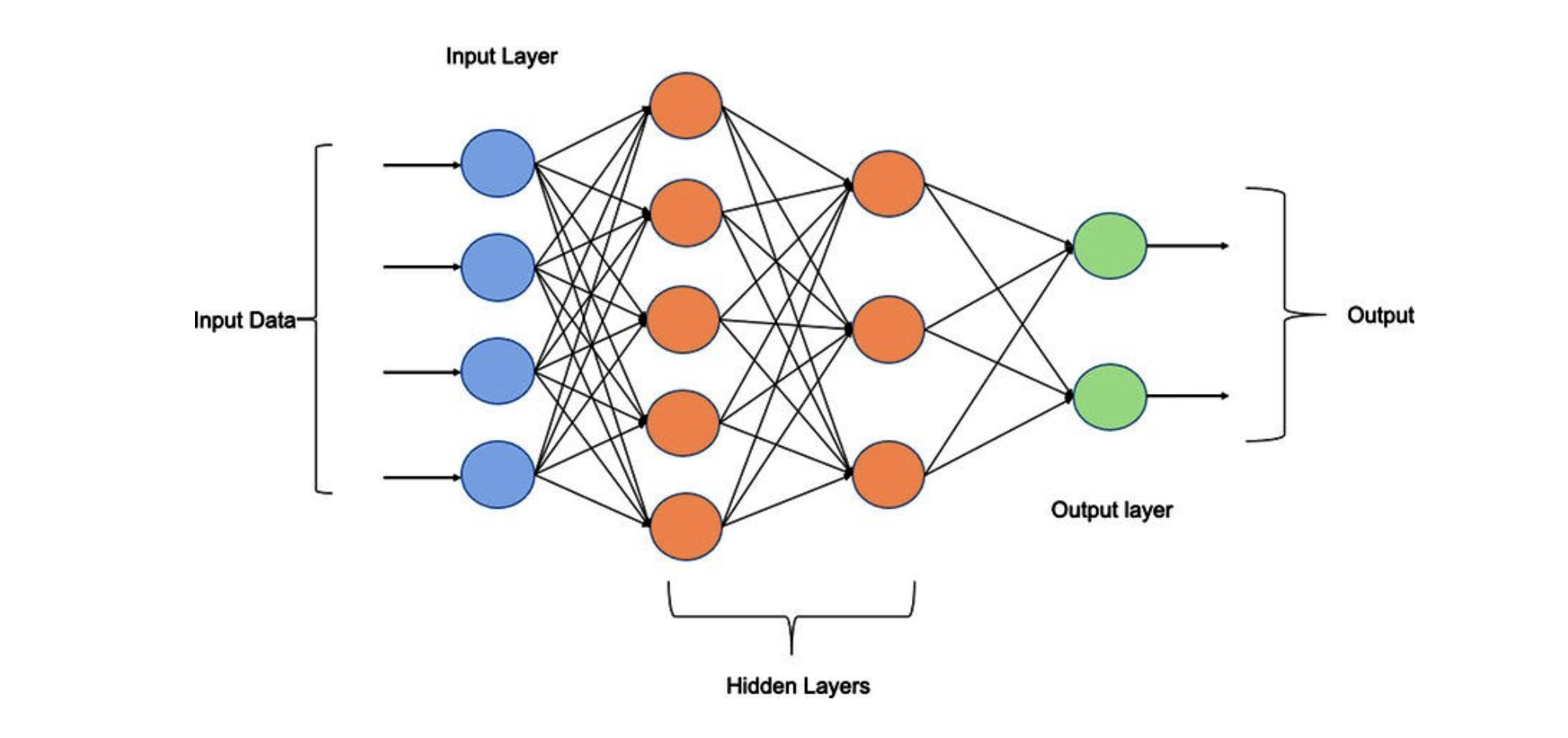

Estas redes suelen dividirse en tres tipos de capas:

- Capa de entrada: recibe los datos originales (por ejemplo, los píxeles de una imagen o las palabras de una oración).

- Capas ocultas: procesan la información internamente, transformándola mediante múltiples combinaciones de pesos y funciones de activación.

- Capa de salida: entrega el resultado final (por ejemplo, “esta imagen contiene un gato” o “la frase traducida es…”).

La fuerza de este enfoque radica en la colaboración: cada neurona individual aporta un pequeño cálculo, pero al trabajar juntas, son capaces de reconocer patrones complejos y resolver problemas que ninguna neurona aislada podría.

Este principio es el que dio lugar al Deep Learning, donde se utilizan decenas o cientos de capas ocultas para tareas avanzadas como el reconocimiento facial, la conducción autónoma o la generación de texto. En esencia, la máquina aprende jerárquicamente: primero identifica rasgos simples y, capa tras capa, combina esos rasgos para reconocer estructuras más complejas.

Fuentes y recursos para profundizar

- Deep Learning (Goodfellow, Bengio y Courville) — Un libro de referencia sobre redes neuronales y aprendizaje profundo.

- Coursera: Neural Networks and Deep Learning (Andrew Ng) — Curso en línea accesible y práctico para comenzar a trabajar con IA.

- TensorFlow Playground — Una herramienta interactiva para experimentar con neuronas artificiales en el navegador.